728x90

1. 비선형 활성화 함수(Activation Functions)

- 신경망의 성능을 향상시키기 위해 사용

- 선형 함수는 입력값과 가중치를 곱한 결과를 그대로 출력하기 때문에 신경망에서 여러 개의 레이어를 사용한다면 최종 출력값은 입력 값과 가중치의 선형 조합으로 표현되므로 입력 데이터의 비선형 관계를 표현할 수 없음

- 신경망이 입력 데이터의 비선형 관계를 잘 학습할 수 있도록 하기 위해 비선형 활성화 함수가 필요

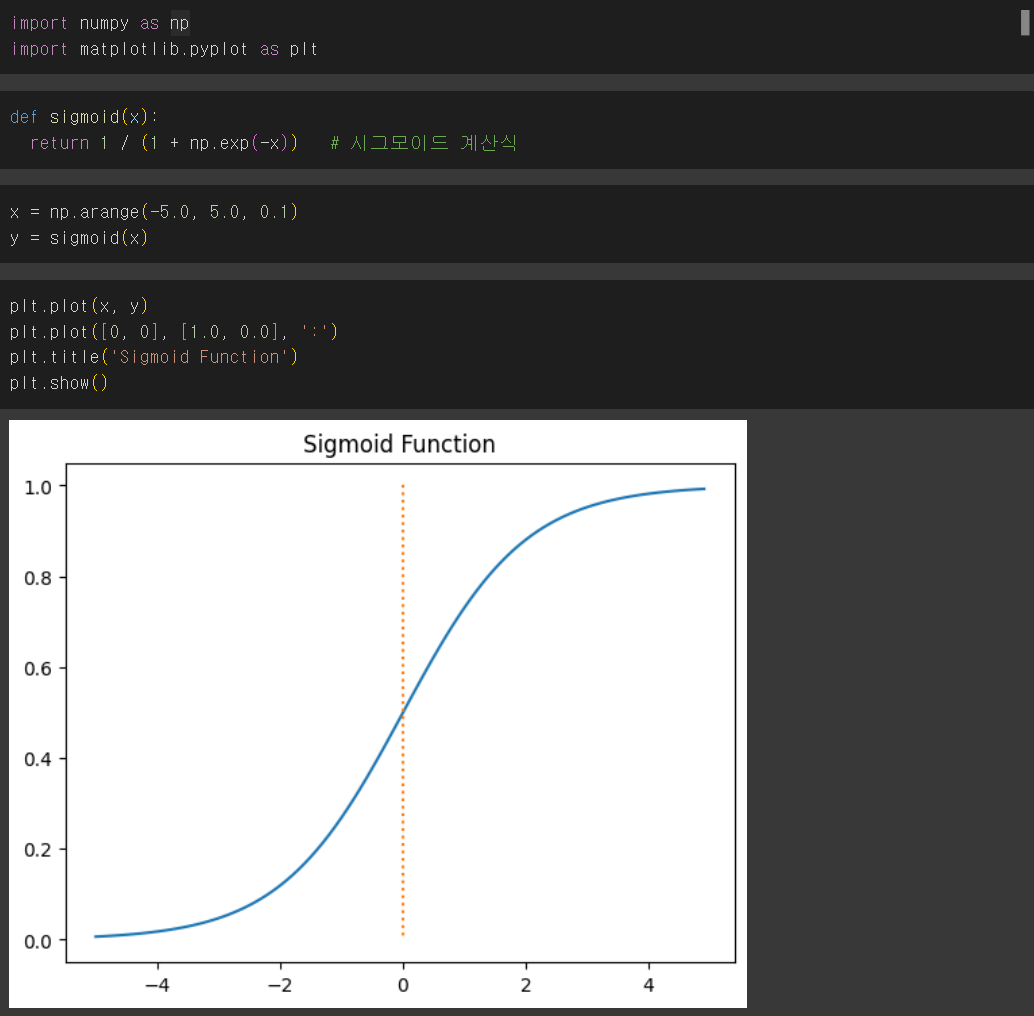

1-1. 시그모이드

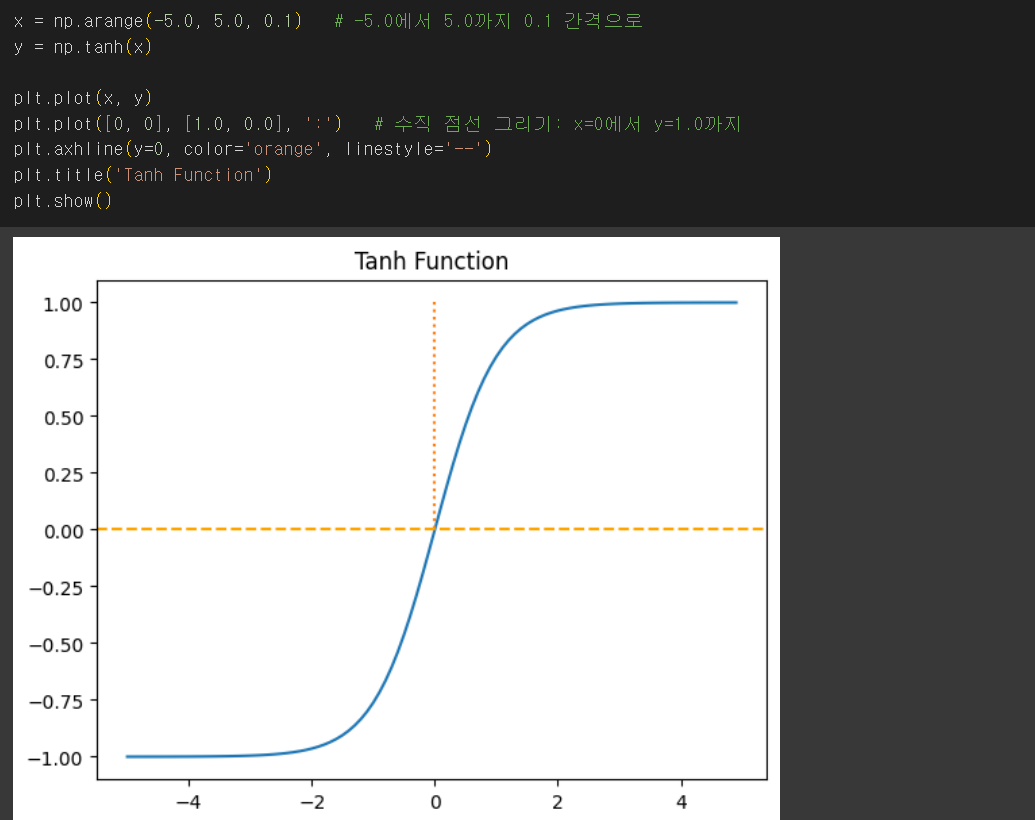

1-2. 하이퍼볼릭탄젠트

- 하이퍼볼릭 사인 함수(sinh)와 하이퍼볼릭 코사인 함수(cosh)로 정의

- 신경망의 활성화 함수로 자주 사용됨

- 출력값이 -1에서 1사이로 조정되어 학습 과정에서 중심화된 데이터 분포를 유지

- 기울기 소실 문제를 완화하는데 도움

1-3. 렐루(relu)

- 신경망에서 널리 사용되는 활성화 함수

- 입력이 양수일 때는 그대로 출력하고, 음수일 때는 0을 출력하는 형태

- 양수 입력에 대해 기울기가 항상 1이므로 기울기 소실 문제를 완화

- 간단한 비교 연산으로 구성되어 계산이 매우 빠름

1-4. 소프트맥스

- 신경망의 출력층에서 활성화 함수로 사용

- 분류 문제에서 각 클래스에 대한 확률을 출력하는데 유용

- 함수의 출력은 0과 1사이의 값으로 변환되며, 출력값은 총합이 1이 됨

- 미분 가능하므로 역전파 알고리즘을 사용할 수 있음

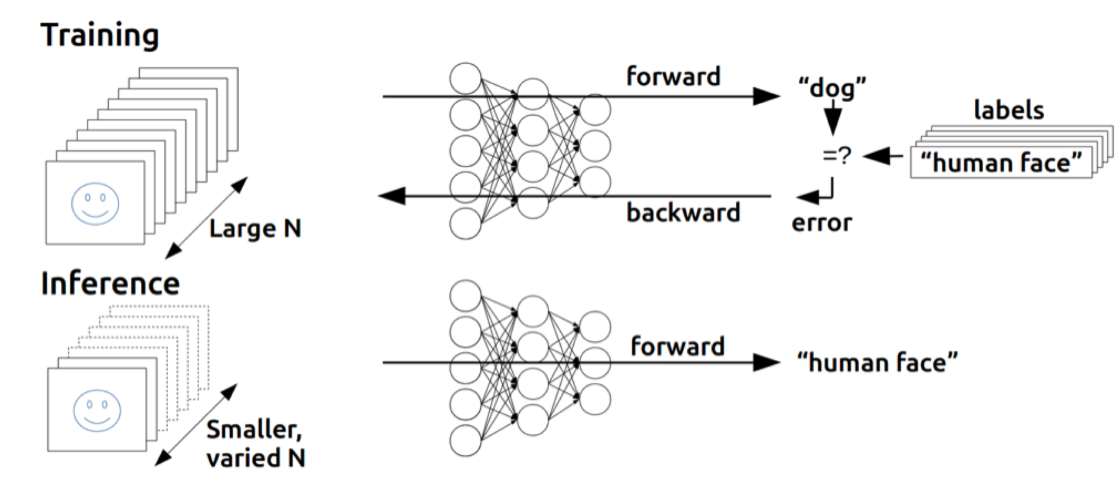

2. 역전파(Backpropagation)

- 1969년 민스키 교수님 XOR는 "지금의 기술로 풀 수 없다"라는 것을 수학적으로 증명함

- 1974년 Paul Werbos에 의해 박사 논문에서 XOR 문제를 해결하게 됨

- 1986년 Hinton에 의해 위와 같은 방법으로 XOR 문제를 해결해 냄(재발견)

- 역전파는 인공신경망에서 학습을 수행하는 데 사용되는 알고리즘으로, 네트워크의 가중치 업데이트하기 위해 오차를 출력층에서 입력층으로 전파하여 각 가중치의 기울기를 계산

- 신경망이 주어진 데이터에 대해 예측을 얼마나 잘하는지 평가하고 네트워크의 가중치를 조정하여 예측 성능을 향상시키는 중요한 과정

3. 역전파 알고리즘의 단계

- 순전파 계산

- 오차 계산

- 기울기 계산

- 가중치 업데이트

728x90